5月13日,技术媒体Marktechpost今天(5月13日)发布了一篇博客文章,报告说苹果

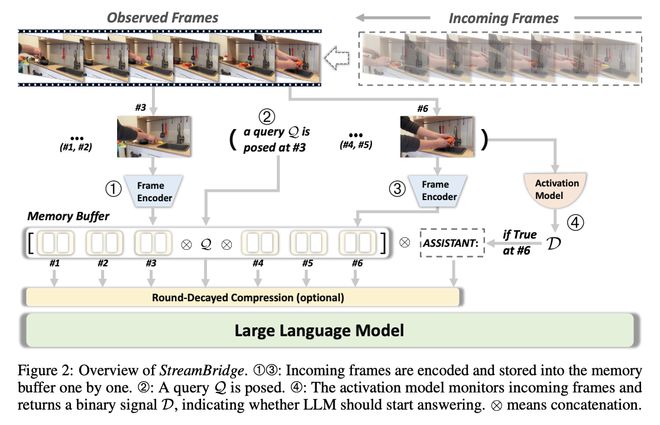

5月13日,技术媒体Marktechpost今天(5月13日)发布了一篇博客文章,报道说,Apple和Fudan University已共同启动了Streambridge端端视频语言(Video-lls)框架的框架,以帮助AI了解实时流媒体视频。了解实时流媒体视频传统大语的挑战和要求在处理静态视频方面非常出色,但是它们并不适应需要实时感知的机器人技术和自动驾驶等场景。在这些情况下,需要该模型快速了解实时流媒体视频的内容并做出反应。现有模型面临两个主要问题:一轮实时理解,也就是说,处理最新的视频剪辑时,应保持对话的历史愿景和背景;其他是一个主动的响应,它要求该模型能够及时监视视频流,并及时地输出反馈,而无需清除Inst开车。 Streambridge和创新技术解决上述问题的框架,苹果和富丹大学的研究人员开发了Streambridge框架。该图通过内存缓冲区和旋转的压缩技术支持长期的上下文关系。该图还引入了一个轻巧的独立激活模型,其中包括现有的视频模型,这些模型是实现主动响应功能的大型语言。研究团队还启动了一个流数据集,其中包含近600,000个示例,结合了MassEsvideo和文本序列,并支持一种多样化的教学格式,以提高视频理解能力。 Streambridge已在主要离线模型上进行了测试,例如Llava-ov-7b,Qwen2-VL-7B和ORYX-1.5-7B。结果表明,OVO板凳和流板板的平均QWEN2-VL得分分别上升到71.30和77.04,超过了所有权模型,例如GPT-4O和Gemini 1.5 Pro。 ORYX-1.5也制作了SI精通的发展,而Llava-ov的性能略有拒绝。溪流数据集的微调进一步提高了所有模型的性能,显示了视频理解领域中强大的Streambridge潜力。 【来源:这在家】

5月13日,技术媒体Marktechpost今天(5月13日)发布了一篇博客文章,报道说,Apple和Fudan University已共同启动了Streambridge端端视频语言(Video-lls)框架的框架,以帮助AI了解实时流媒体视频。了解实时流媒体视频传统大语的挑战和要求在处理静态视频方面非常出色,但是它们并不适应需要实时感知的机器人技术和自动驾驶等场景。在这些情况下,需要该模型快速了解实时流媒体视频的内容并做出反应。现有模型面临两个主要问题:一轮实时理解,也就是说,处理最新的视频剪辑时,应保持对话的历史愿景和背景;其他是一个主动的响应,它要求该模型能够及时监视视频流,并及时地输出反馈,而无需清除Inst开车。 Streambridge和创新技术解决上述问题的框架,苹果和富丹大学的研究人员开发了Streambridge框架。该图通过内存缓冲区和旋转的压缩技术支持长期的上下文关系。该图还引入了一个轻巧的独立激活模型,其中包括现有的视频模型,这些模型是实现主动响应功能的大型语言。研究团队还启动了一个流数据集,其中包含近600,000个示例,结合了MassEsvideo和文本序列,并支持一种多样化的教学格式,以提高视频理解能力。 Streambridge已在主要离线模型上进行了测试,例如Llava-ov-7b,Qwen2-VL-7B和ORYX-1.5-7B。结果表明,OVO板凳和流板板的平均QWEN2-VL得分分别上升到71.30和77.04,超过了所有权模型,例如GPT-4O和Gemini 1.5 Pro。 ORYX-1.5也制作了SI精通的发展,而Llava-ov的性能略有拒绝。溪流数据集的微调进一步提高了所有模型的性能,显示了视频理解领域中强大的Streambridge潜力。 【来源:这在家】